编辑:Mavis 发布:2019-11-22 10:42

近期,英伟达宣布推出Magnum IO软件组,能够帮助研究人员在数分钟内处理大量复杂的数据,数据迁移速度比以往提升20倍。

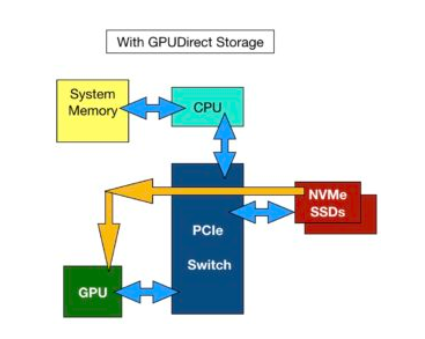

Magnum IO软件组的核心是GPUDirect Storage,数据可以绕过CPU,在GPU、存储设备和网络设备提供的“开放高速公路”上进行传输。由点对点及远程直接内存访问(RDMA)组成的GPUDirect存储,可兼容多种通信互联产品与API,其中包括NVIDIA NVLink、NCCL、OpenMPI及UCX。

使用Magnum IO软件组实现的数据加载方式

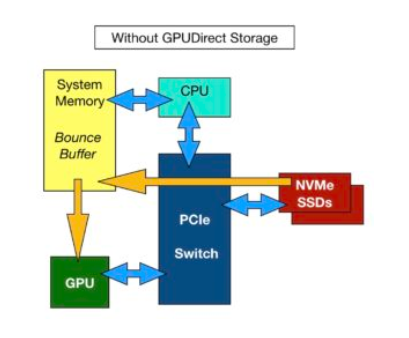

在传统的数据传输方式中,数据需要三跳才能从存储设备传输到GPU中,每次跳跃都需要时间,主机服务器内存会在存储设备和GPU之间充当临时的跳动缓冲区。GPU通过网络接口卡接收从本地或外部存储中获取的数据。这将被临时存储在主机服务器的DRAM中,并通过PCIe连接传输到GPU。

传统GPU数据加载方式

传统方式中,从主机服务器内存中到英伟达GPU的带宽最大为50GB/s。Magnum IO软件组能够支持多服务器,多GPU计算节点配置,多个SSD和网络适配器组合带宽可达215GB/s。

英伟达创办人暨首席执行官黄仁勋表示:“处理大量收集或仿真的数据,是AI这样由数据带动的科学研究领域的核心。随着数据的规模和出现速度呈现指数级增长,数据中心所面临的巨大挑战和成本考量就是数据处理。极致的运算需要有极致的输入/ 输出功能,而Magnum IO将颠覆运算领域的NVIDIA GPU加速技术用在输入/ 输出功能和存储设备上,做到了这一点。如今AI研究人员与数据科学家不用再等待数据,反而能专心在他们的研究工作上。”

现在Magnum IO软件组已经上市,但GPUDirect Storage暂时只为部分用户提供早期访问权限。黄仁勋表示,英伟达计划在2020年上半年向所有客户提供GPUDirect Storage。

深圳市闪存市场资讯有限公司 客服邮箱:Service@ChinaFlashMarket.com

CFM闪存市场(ChinaFlashMarket) 版权所有 Copyright©2008-2023 粤ICP备08133127号-2